DeepSeek本地部署教程,0基礎DeepSeek本地部署攻略!

AI教程 2025-04-29

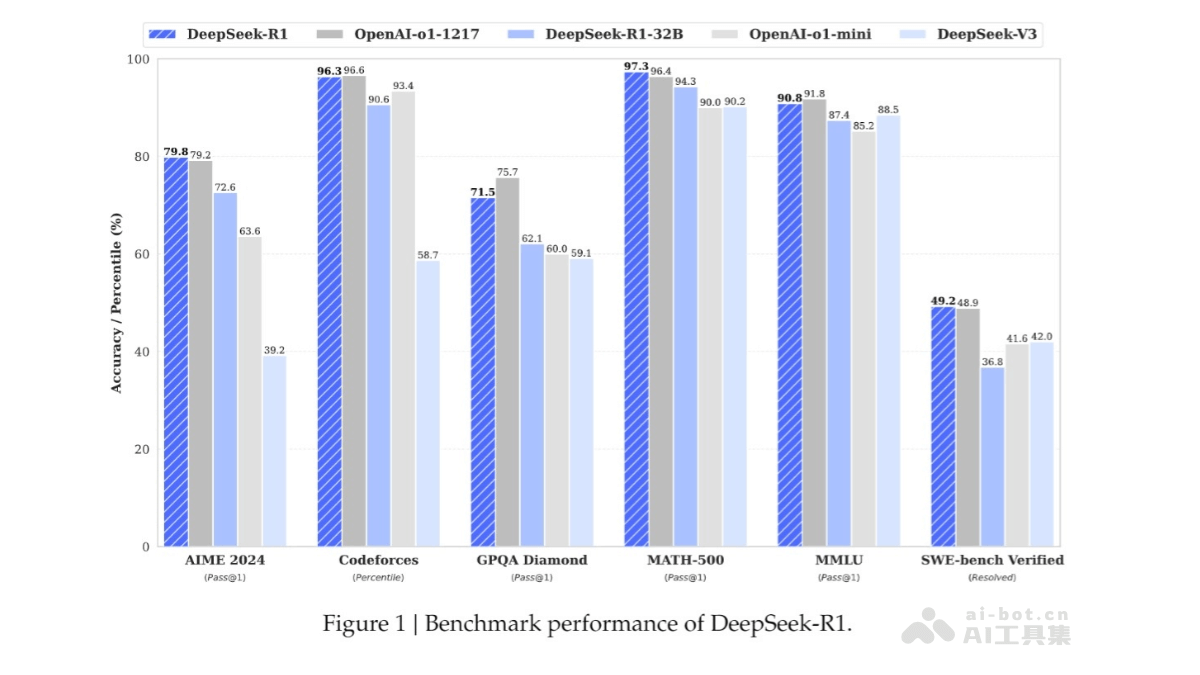

DeepSeek R1全球爆火,不需要專業的prompt撰寫能力,只要能說清楚問題,就算你是只會打字的小學生,也能獲得高質量的回答。開發成本、輸出質量全面領先OpenAI o1。

美中不足的是,它訪問量太大了,以至于經常罷工。

很多人就開始用其他接入了R1的平臺。有人就要問了,博主博主,其他接入R1的平臺確實很強,但還是太吃Token了,有沒有免費、又簡單的方法用到DeepSeek R1呢?

有的兄弟,有的。

直接在電腦上本地部署R1,就可以!無需聯網、不用擔心數據泄露、完全免費,還可以搭建個人知識庫,訓練你的專屬AI助理。

01

部署流程

本地部署只需要三步:

安裝Ollama

下載DeepSeek-R1大模型

使用Cherry Studio調用模型

Ollama的模型庫里的40多種開源模型,比如阿里云通義千問推出的大模型Qwen2.5,Meta公司最新的大模型Llama 3.3等等,都可以通過這套流程來本地部署。

操作簡單,0基礎有手就會,而且完全免費!

接下來我們一步一步還原一下本地部署DeepSeek-R1大模型的全過程。

02

安裝Ollama

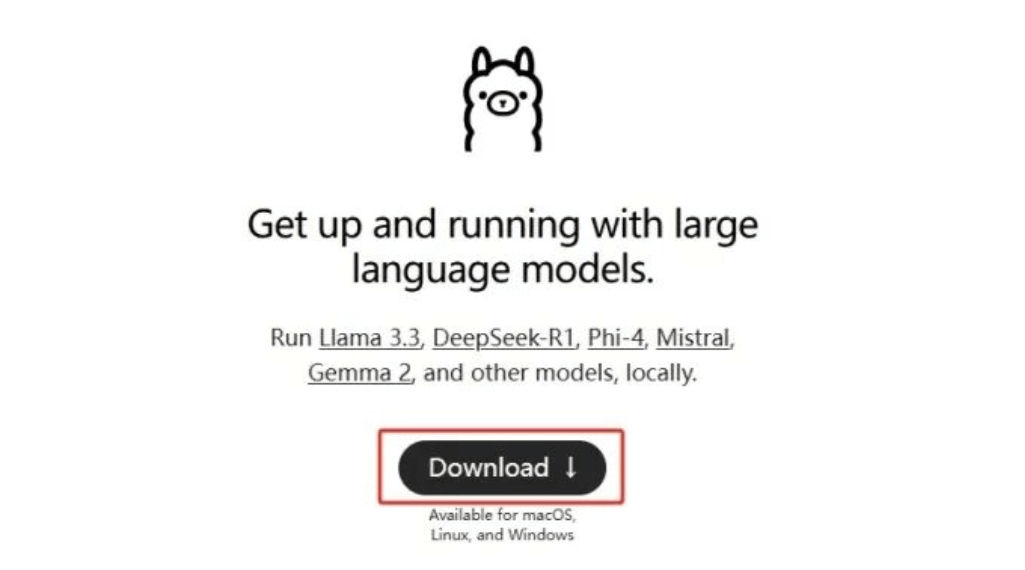

Ollama是一個在本地計算機上運行大模型的命令行工具,有了它,你就可以在本地跑大模型。

進入Ollama官網登錄,點擊Download。

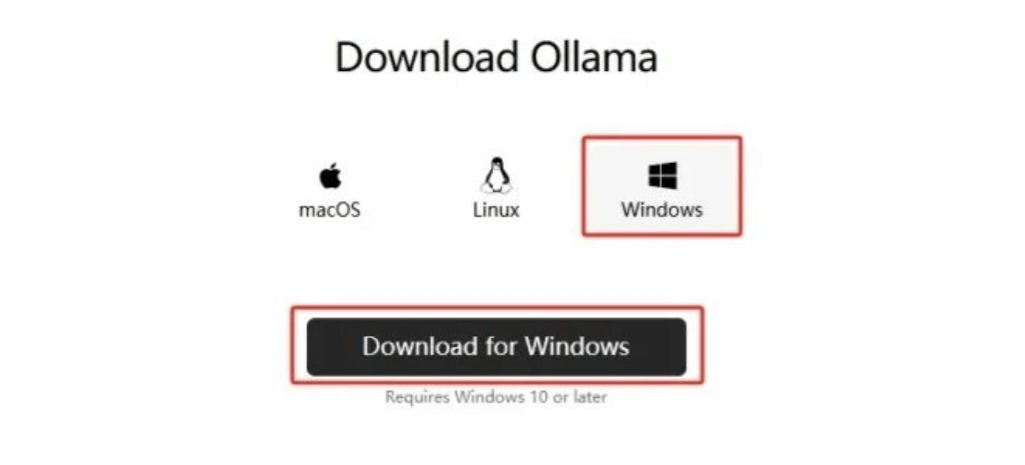

我用的是Windows系統,所以直接選擇Windows的版本下載。

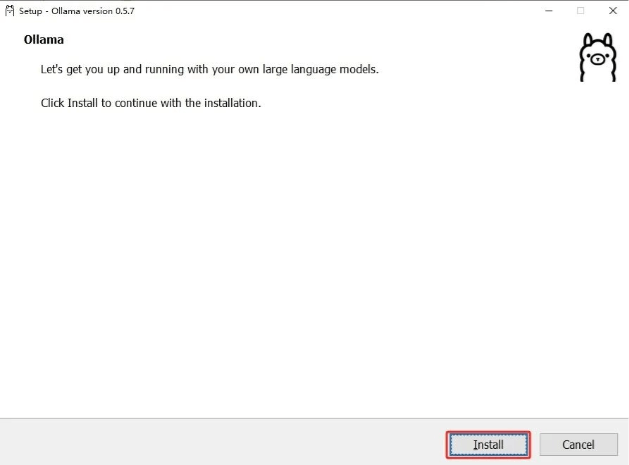

下載完點擊安裝,會默認安裝在C盤,Windows版本不支持修改安裝位置,所以我們無腦點“下一步”就行啦!

注意,安裝完成后右下角會彈出提示框,點擊“確認”,點擊即可彈出窗口。

Ollama就安裝成功啦。

03

部署DeepSeek R1模型

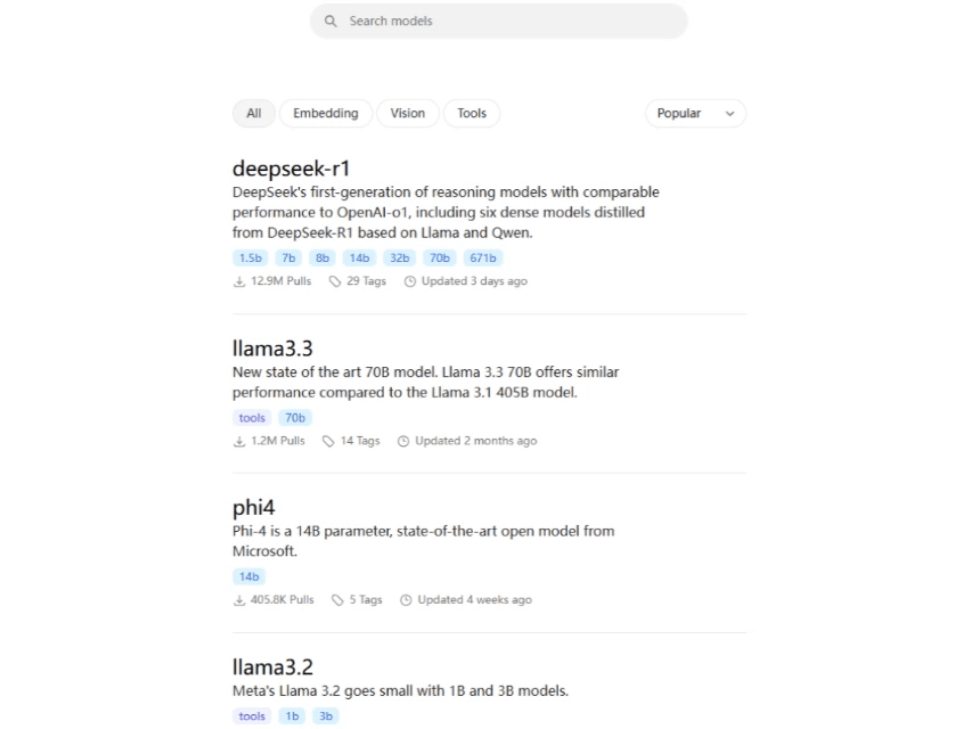

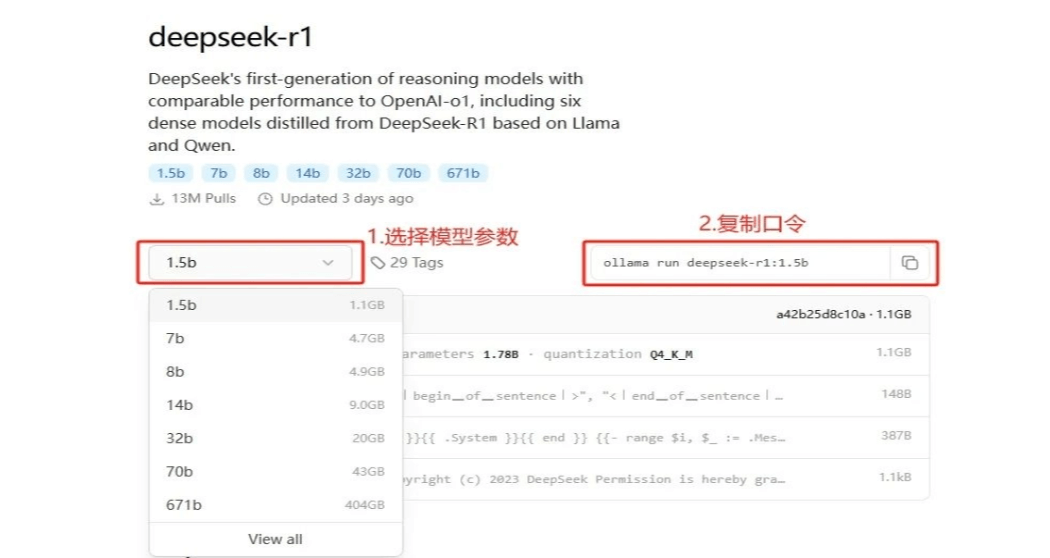

我們回到Ollama官網,點擊左上角的“Models”進入模型庫,點擊DeepSeek-R1大模型。

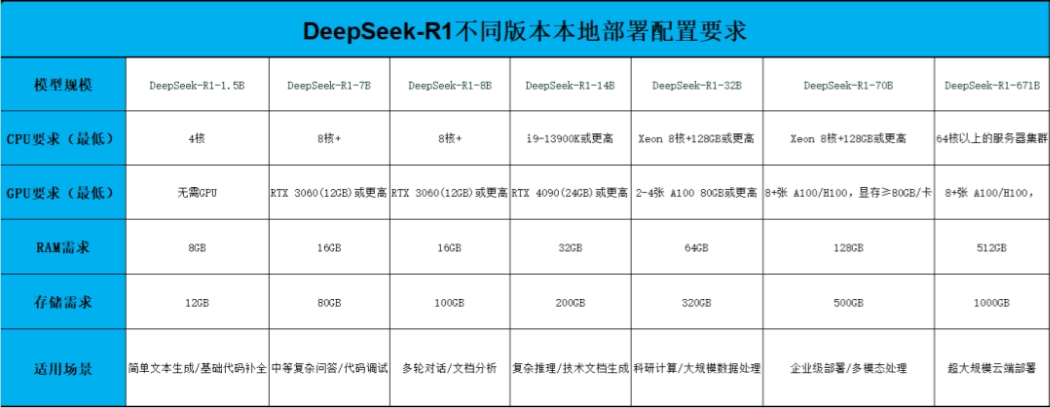

Ollama提供7種不同參數的模型可供下載。

R1的模型參數是671B,差不多需要1300個G的顯存,你才能跑得動滿血版R1。

1.5B到70B是R1的蒸餾版,模型能力雖然不如滿血版(參數數字越大能力越強),但是對硬件要求更低,在同規模的開源模型里表現也是很突出的,適合個人或企業本地部署。

我總結了一份DeepSeek-R1每個版本的配置要求的表格,大家可以對照選擇:

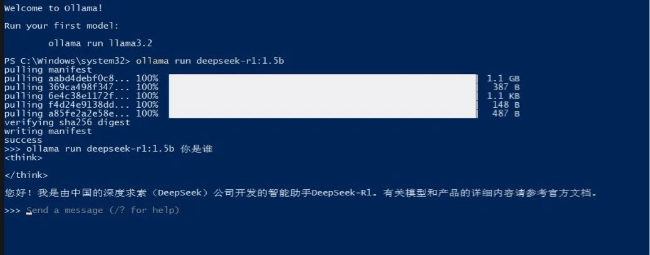

這里我選擇1.5B的模型,復制后面口令:ollama run deepseek-r1:1.5b

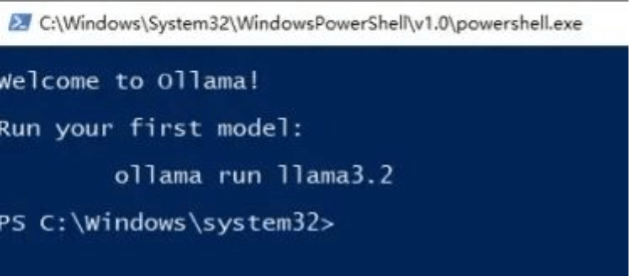

把口令粘貼進Ollama彈出的窗口中,按回車,就會開始下載模型。

靜靜等待進度條到100%,最后提示“success”,就說明下載完成了。

我們在命令行輸入ollama run deepseek-r1:1.5b+問題,就能直接與AI對話。

但是這個界面看著太簡陋了,而且每次提問都要復制一行命令,也不太方便。

接下來我們通過客戶端來優化這個問題。

04

通過Cherry Studio調用模型

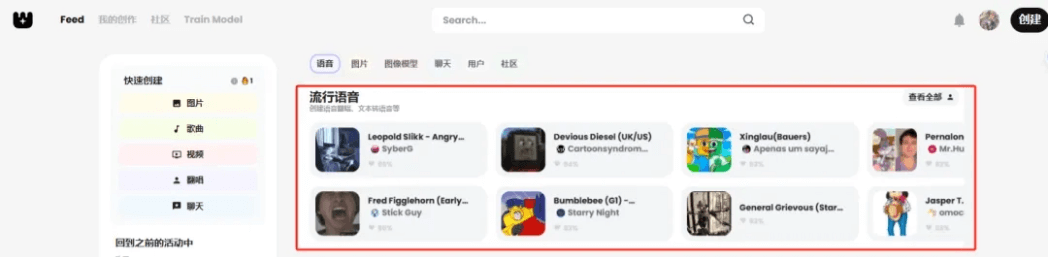

Cherry Studio是一款開源的多模型桌面客戶端。它可以直接調用主流的大模型,比如OpenAI、Gemini,和本地模型。

像這樣開源、好用的客戶端還有Chatbox AI、AnythingLLM等等。

官方也整理過一份實用集成文件,可以幫我們更好地應用DeepSeek。

這里我們以Cherry Studio為例,一起操作一下。

進入Cherry Studio官網的下載界面,可以點擊立即下載,或者從網盤鏈接下載。

安裝步驟也是直接點下一步即可。

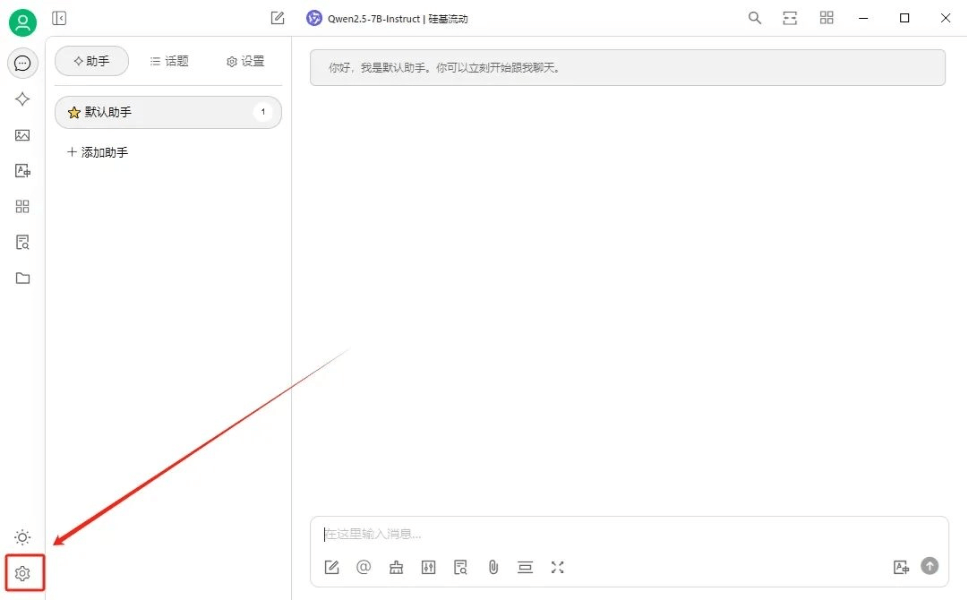

安裝后點擊左下角的設置。

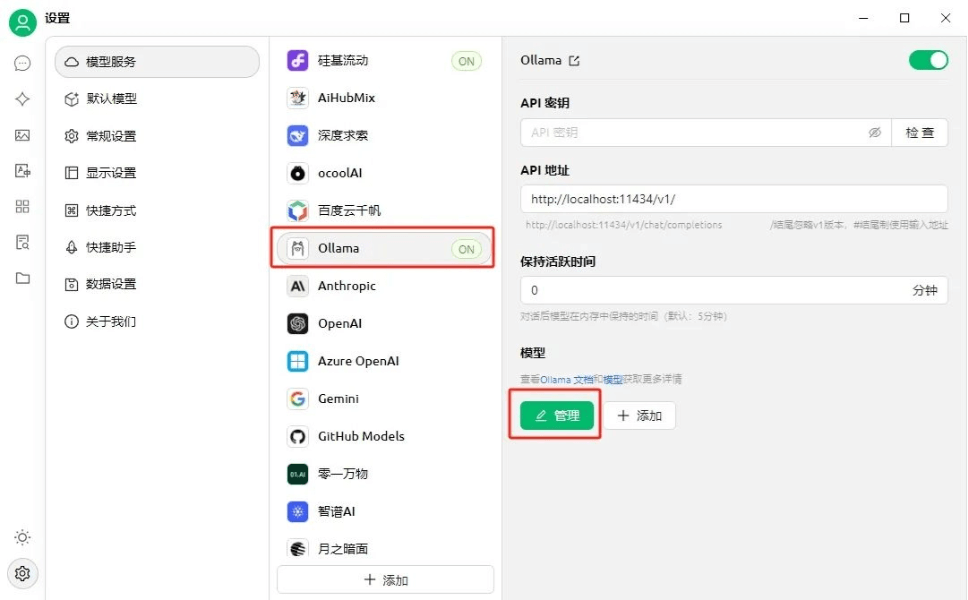

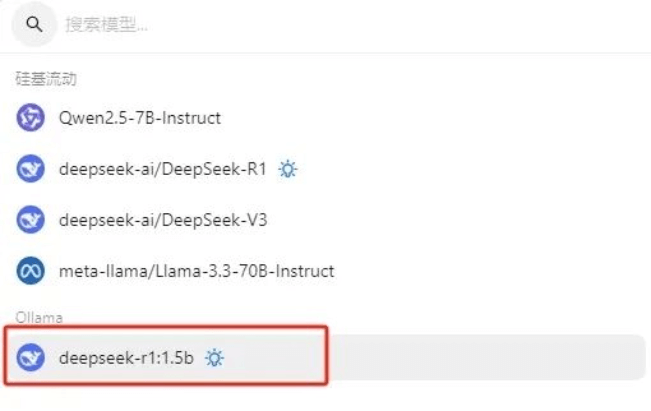

在模型服務里選擇Ollama,點亮右上角的啟用,API密鑰會自動填寫,然后點擊管理。

可以看到本地已經安裝好的DeepSeek-R1模型,點擊右邊的+號。

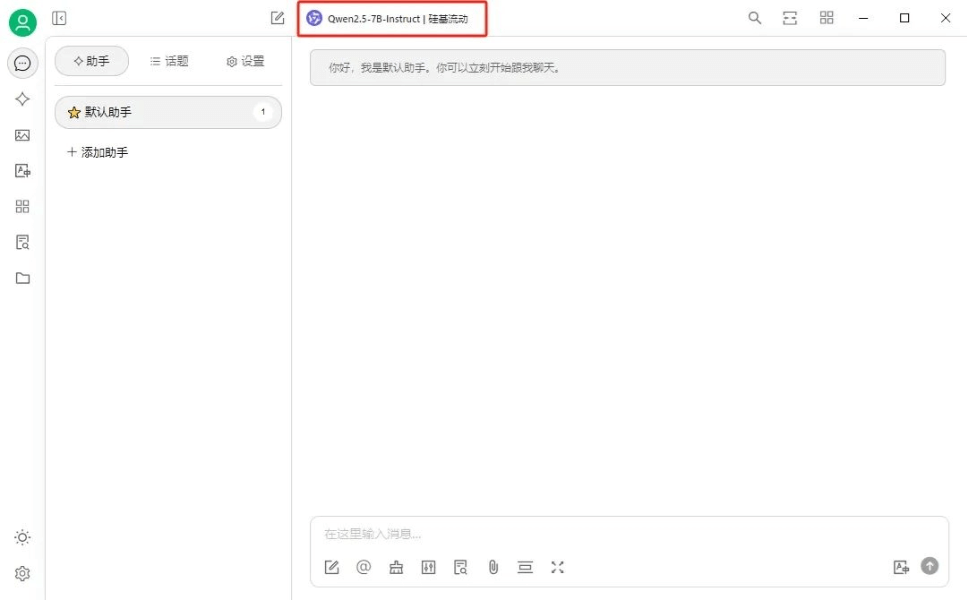

我們返回到首頁,點擊頁面上方顯示的模型名稱。

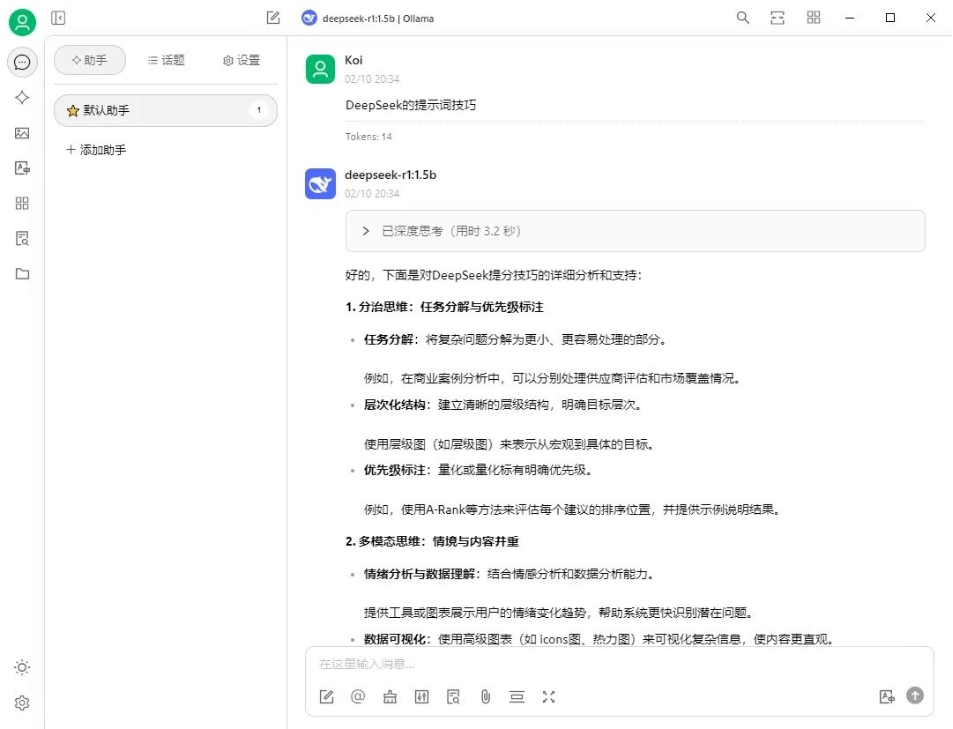

點擊選擇我們本地部署的DeepSeek-R1:1.5B。

就可以跟AI正常對話啦。

1.5B的模型泛用性不是太強,適合做一些簡單的問答,如果想要將本地部署的R1應用在工作中,推薦7B或者更高參數的版本。

本地部署DeepSeek,有響應及時、免費、個性化程度高的優勢,但是對配置有一定的要求,有合適的設備可以試試。

學會這個步驟,你可以在本地部署任意一款開源的大模型,快去試試吧!

本文轉載自互聯網,如有侵權,聯系郵箱:478266466@qq.com 刪除